Puede ser difícil saber a primera vista si lo que ves es real; a veces las notas de la comunidad añaden contexto, pero a veces no.

PolitiFact verificó algunas de las imágenes y videos engañosos sobre el ataque estadounidense y la reacción al mismo. Aquí tienes una guía de lo que debes evitar y consejos sobre cómo verificar las imágenes dudosas.

Buscar inconsistencias

Una cuenta de X con marca azul llamada «Ukraine Front Line» publicó un video el 22 de junio en el que se ve un rayo atravesando un gran hongo de humo naranja sobre una ciudad. El pie de foto advertía de una guerra nuclear: «¡Por favor, presten atención a los relámpagos! Es la señal más segura de que la explosión fue realmente nuclear».

Ese video no muestra un suceso real. Fue subido el 18 de junio a YouTube con la leyenda «ai video». La descripción de la cuenta detalla que todos los videos del canal están producidos con inteligencia artificial.

Algunos modelos de IA generativa permiten escribir instrucciones para generar videos realistas, y los resultados son cada vez más sofisticados.

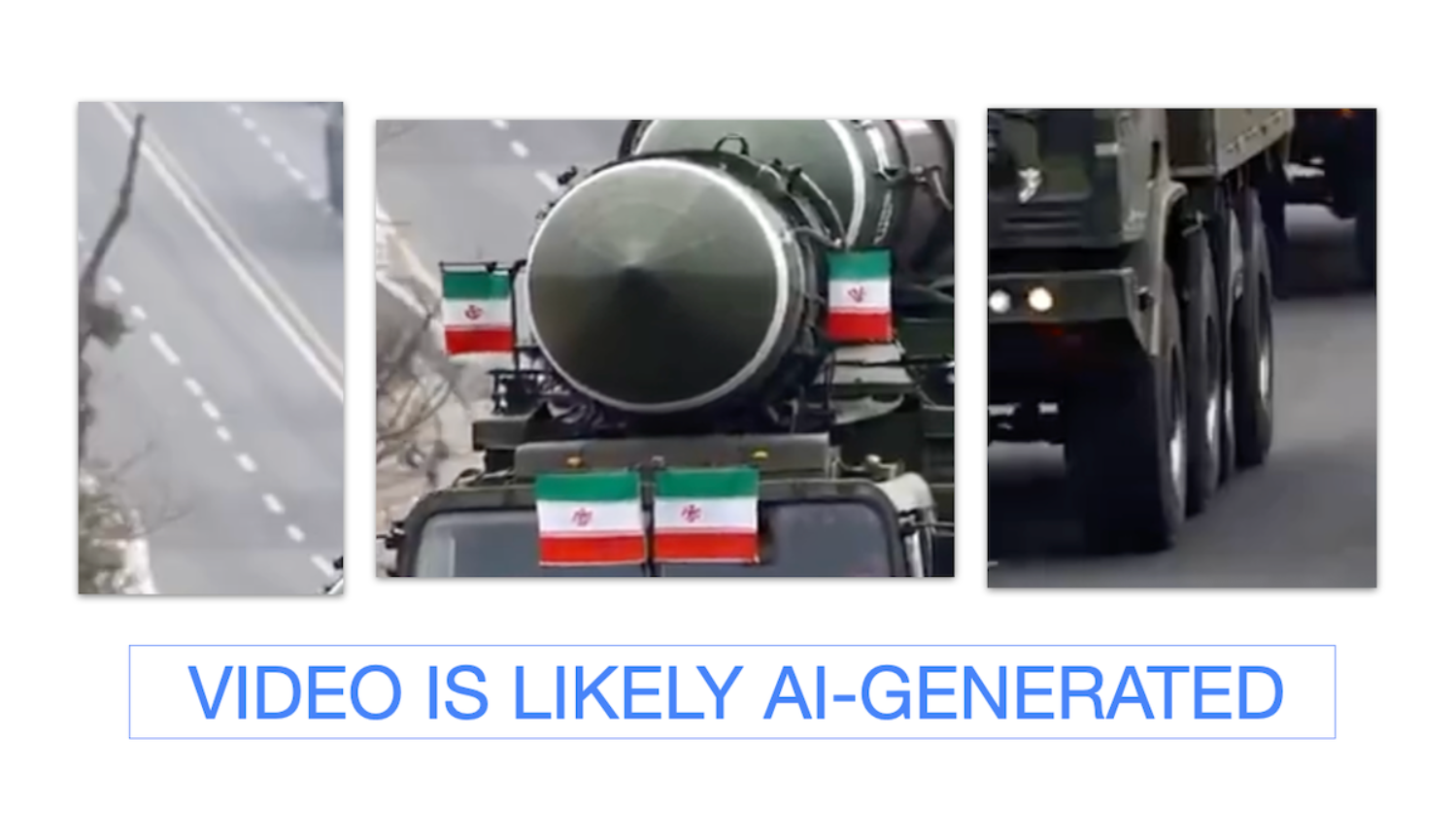

Pero no son perfectos, y si se observan de cerca, los videos revelan incoherencias visuales. Uno titulado «Preparándose para el ataque de esta noche», mostraba supuestos camiones con banderas iraníes que transportaban misiles. Una mirada más atenta muestra que las líneas de la carretera son desiguales, que un neumático del segundo camión parece tener un trozo arrancado y que los caracteres de las banderas no coinciden con la bandera iraní.

Hany Farid, profesor de la Universidad de California en Berkeley especializado en análisis forense digital, escribió en LinkedIn que muchos videos generados por inteligencia artificial suelen durar ocho segundos o menos, o están conformados por clips de ocho segundos editados juntos. Esto se debe a que Veo 3 de Google, un modelo de conversión de texto a video, tiene un límite de ocho segundos. Algunos videos tienen marcas de agua visibles, pero los usuarios pueden recortarlas.

En los últimos años no ha prevalecido la desinformación generada con IA durante los eventos de última hora, pero durante esta guerra, tanto las cuentas proisraelíes como las proiraníes han compartido este tipo de contenidos. Emmanuelle Saliba, jefa de investigación de la empresa de análisis forense digital Get Real Labs, dijo a BBC Verify que era la primera vez que habían visto el uso a escala de IA generativa durante un conflicto.

Encontrar el contexto original

Junto al creciente uso de la IA por parte de los desinformadores, no han faltado imágenes y videos sacados de contexto.

«Protestas masivas estallan en Estados Unidos mientras los ciudadanos salen a la calle indignados después de que Estados Unidos atacara Irán», rezaba el pie de foto de una publicación en X del 22 de junio. Pero el video se subió originalmente el 14 de junio, día de las protestas «No Kings» en todo el país.

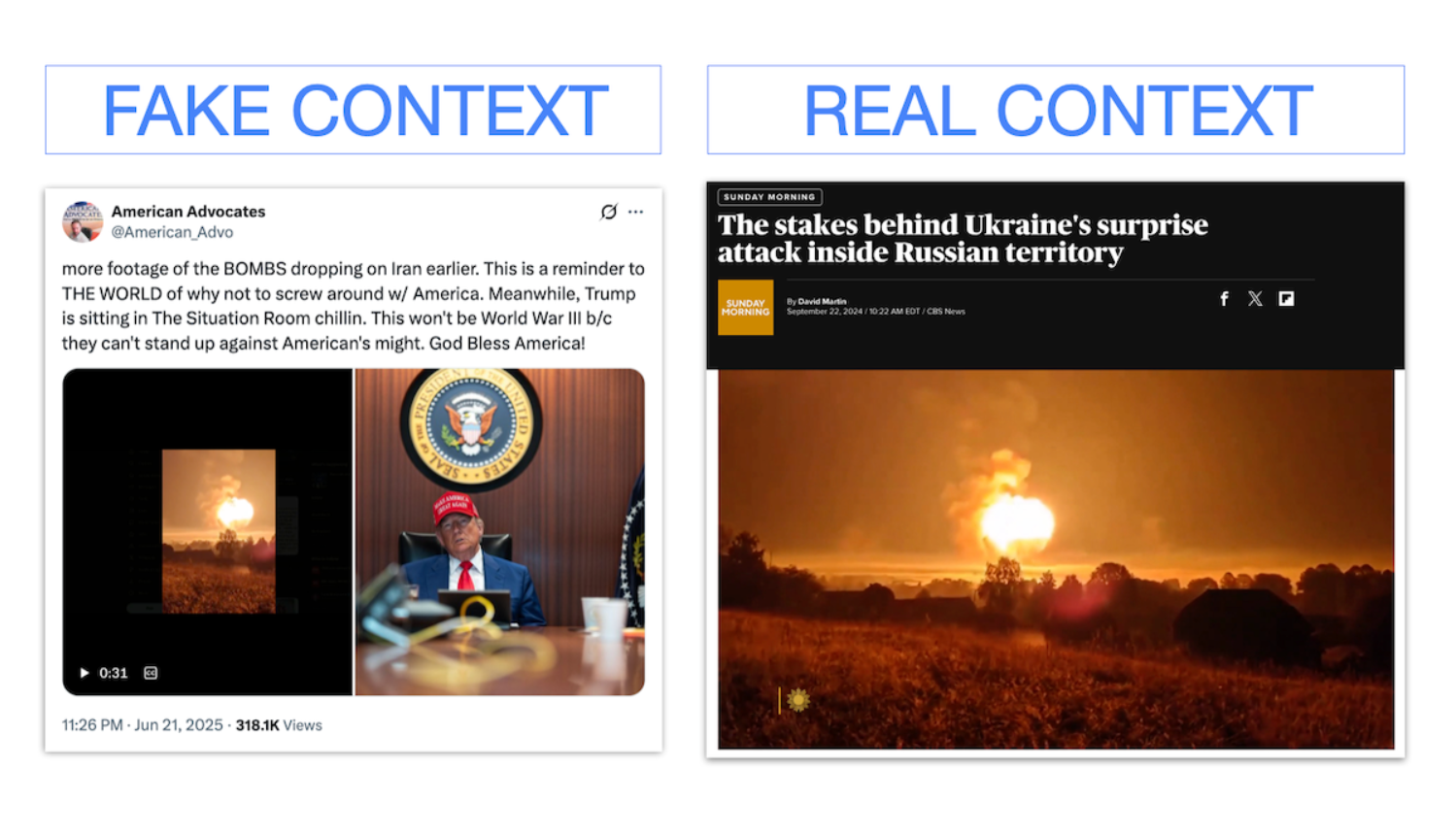

Otro video compartido la noche de los ataques estadounidenses mostraba una gran columna de fuego y humo. «Más imágenes de las BOMBAS que cayeron sobre Irán», se leía. Sin embargo, las imágenes procedían de un ataque ucraniano de 2024 contra Rusia.

Una búsqueda inversa de imágenes puede revelar si un video se ha publicado antes en Internet y cuál era el contexto original. Herramientas como Google Lens y TinEye pueden mostrar dónde se compartieron imágenes o videos en distintas plataformas, quién los publicó originalmente y en qué fecha. Los pies de foto de las imágenes publicadas por los medios de comunicación muestran en general cuándo y dónde se tomaron.

Uso de videojuegos

Imágenes grabadas de simuladores de vuelo y videojuegos también se viralizan como si fuesen reales.

«¡Este es el bombardero furtivo B2 Spirit despegando en California!», decía una publicación en X del 21 de junio hecha desde una cuenta verificada, antes del ataque a Irán.

Pero no era un bombardero B2 real. Al verificar la marca de agua del video, se llega a una cuenta de TikTok que publicó el video el 15 de mayo con el hashtag «#microsoftflightsimulator», un juego de simulación disponible en Xbox.

El videojuego Arma también es susceptible de ser utilizado durante conflictos armados. Ocurrió con la guerra en Ucrania y la de Gaza.

Búsquedas por palabras clave en plataformas como YouTube pueden mostrar si los videos coinciden con material previamente subido de videojuegos.

Cómo identificar la autenticidad de una cuenta

Verificar el perfil y la biografía de una cuenta suele revelar si es confiable o no. Muchas afirmaciones falsas y engañosas proceden de cuentas con la bandera iraní como foto de perfil y nombres que pueden confundirse con medios legítimos como «Iran Updaes Commentary» (errata incluida), o «Iran News Daily Commentary». Otra cuenta —con un tilde azul— se llama «Iran’s Reply».

Estas cuentas no están afiliadas al gobierno iraní ni a ninguna fuente creíble. PolitiFact descubrió que las publicaciones de estas cuentas obtienen cientos de miles, sino millones, de visitas, pero contienen contenidos de baja calidad, incluyendo imágenes generadas por IA.

Este artículo fue originalmente publicado por PolitiFact y se reproduce y traduce en IJNet con permiso.

Foto de DMV Photojournalism vía Pexels.