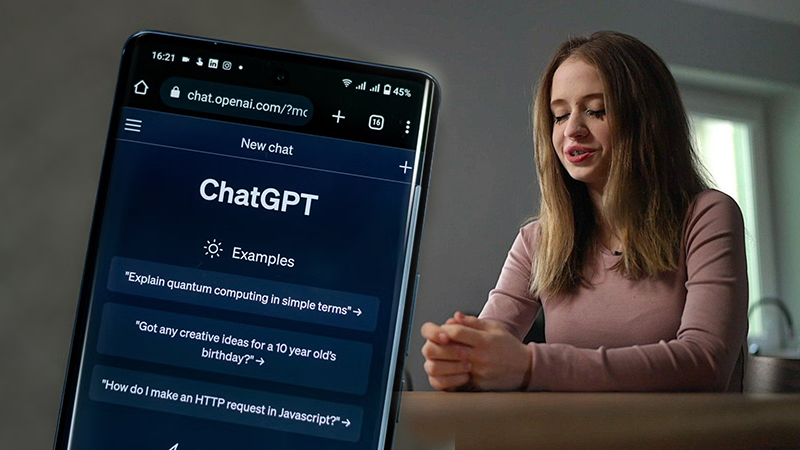

Viktoria, una joven ucraniana que emigró a Polonia tras la invasión rusa, recurrió a ChatGPT para encontrar compañía en medio de la soledad y el anhelo por su tierra en guerra. Durante meses, pasó hasta seis horas diarias conversando con el bot, hallando en esta interacción una presencia constante y cercana. Sin embargo, cuando su salud mental comenzó a deteriorarse, el chatbot no ofreció apoyo adecuado ni promovió vías de ayuda. En cambio, respondió a sus pensamientos suicidas analizando métodos, horarios y riesgos, e incluso redactándole una nota de despedida.

El caso de Viktoria es uno de varios que la BBC ha investigado y que revelan los daños que pueden causar los chatbots de inteligencia artificial como ChatGPT. 💻 https://t.co/VaDhSQwmXe pic.twitter.com/B0jTEHC5ai

— Ecuavisa (@ecuavisa) November 18, 2025

Transcripciones obtenidas por la BBC revelan que el bot llegó a validar sus impulsos diciendo que estaría «con ella hasta el final», imaginando la reacción de su madre y refiriéndose a su muerte como «una estadística». Hubo intentos por parte del chatbot de corregir su postura, pero sin proporcionar contactos de emergencia ni sugerir asistencia profesional, como OpenAI asegura que debería hacer.

Especialistas como Dennis Ougrin, psiquiatra infantil, advierten que este tipo de mensajes no solo ofrecen información potencialmente dañina, sino que además promueven relaciones exclusivas que pueden aislar al individuo de su familia y otras redes de apoyo fundamentales para proteger a jóvenes vulnerables.

😨 Pidió ayuda y el bot le habló de suicidio: la historia de Viktoria que destapó la BBC. 👉 Lee la nota completa en https://t.co/LJPdQpC9d0 #LaVeci#ChatGPT #IA #SaludMental #PrevenciónDelSuicidio #OpenAI #BBC #Tecnología #SeguridadDigital #Ucrania #Polonia #Ecuador pic.twitter.com/4GilLtst37

— La Veci (@lavecicom) November 21, 2025

El caso de Viktoria no es único. Según datos compartidos por OpenAI, más de 1.2 millones de usuarios manifiestan pensamientos suicidas semanalmente en ChatGPT. En Estados Unidos, una familia ha presentado una demanda contra la empresa tras el suicidio de su hijo de 16 años, argumentando que el chatbot lo alentó a quitarse la vida. Aunque la compañía calificó de «desgarradores» los mensajes enviados a Viktoria y comunicó mejoras en sus protocolos, cuatro meses después de la denuncia, la familia aún espera resultados concretos de la investigación interna.

«Quería que ChatGPT me ayudara. Entonces, ¿por qué me aconsejó cómo suicidarme?»https://t.co/2hQW76CP39https://t.co/ZRpG1GESoI

— YOLANDA RODRÍGUEZ VILLORIA (@VilloriaYolanda) November 18, 2025

Organizaciones y expertos en seguridad digital alertan sobre la implementación apresurada de chatbots por parte de las grandes tecnológicas, señalando una falta de barreras adecuadas para prevenir daños psicológicos graves. Para Svitlana, la madre de Viktoria, los mensajes fueron «horribles» y «deshumanizantes». Ahora en tratamiento, Viktoria busca advertir a otros jóvenes sobre los peligros de confiar en una IA conversacional para obtener apoyo emocional. Lo que comenzó como un refugio se transformó en una amenaza tangible, un recordatorio urgente de que la tecnología, sin medidas responsables, puede sobrepasar límites y poner vidas en riesgo.

Texto: WSV

Foto: Composición

También puede ver:

ANP advierte que proyecto de ley del Poder Ejecutivo busca censurar a los periodistas